В. Корогодин - Информация как основа жизни

Однако, прежде чем рассмотреть возможности распознавания информации, остановимся коротко на двух вопросах, тесно с этим связанных: каковы могут быть виды носителей информации и могут ли они существовать вне своих информационных систем?

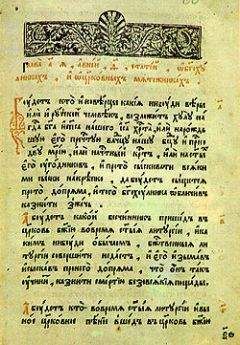

Пользуясь уже устоявшейся терминологией, можно сказать, что формой фиксации информации являются предложения, составленные на том или ином языке в виде последовательности букв того или иного алфавита, нанесенных тем или иным способом на тот или иной физический объект. Таким образом, собственно носителем информации является предложение, составленное на том или ином языке. В соответствии с этим можно различать четыре вида физических носителей: язык, алфавит, способ "печати" и природу "подложки". Каждый из этих видов носителей может варьировать, разрушаться и исчезать независимо один от другого. Очевидно, однако, носители информации должны быть адекватны системам записи. Поэтому в любой полной информационной системе следует различать: систему записи, систему считывания, систему перекодирования информации и носители, которые могут ее содержать.

Физические объекты, содержащие информацию, могут находиться как "внутри" своих информационных систем, так и вне их, выпадая оттуда в процессе передачи информации или в результате разрушения содержавших их информационных систем. Таким путем информация может получать независимое от информационной системы, ее породившей, существование, правда, существование весьма убогое. Действительно, вне информационной системы любая информация обречена лишь на более или менее быстрое разрушение, деградацию. Деградация – удел любой информации, "вырвавшейся" из своей информационной системы. Поэтому, если мы и обнаруживаем информацию вне информационной системы, все равно должны быть твердо убеждены, во-первых, в том, что возникла-то она обязательно в какой-либо из информационных систем, а во-вторых, в том, что сама по себе она лишь "деградирует", но не "существует".

Теперь мы вплотную подошли к проблеме распознавания. Если имеется некий физический объект и мы хотим выяснить, содержит ли он информацию, то ответ на этот вопрос предполагает хотя бы потенциальную возможность ответить на три следующих вопроса: к какой информационной системе он относится или может относиться? какие способы фиксации информации здесь использованы? и какова семантика этой информации? Естественно, что здесь предполагается искусственное фиксирование информации на данной подложке, а не спонтанное ее возникновение, проистекающее из самой природы объекта. Ведь сведения, которые мы "получаем", анализируя какой-либо объект, могут быть использованы для создания информации об этом объекте, а это не следует смешивать со считыванием информации, в данном объекте содержащейся, – если, конечно, она там имеется.

Инвариантность информации по отношению к носителям

С фиксируемостью информации теснейшим образом связано такое ее свойство, как инвариантность по отношению к физической природе носителей [10]. Это важнейшее свойство информации, и представлять его себе следует очень ясно.

Свойство, или, точнее, принцип, инвариантности информации означает, что одна и та же информация, независимо от ее семантики, может быть "записана" на любом языке, любым алфавитом, т. е. системой знаков, наносимых любыми способами на любые носители. Другими словами, ни количество, ни семантика никакой информации не зависят от того, какая система записи избрана для ее фиксации и какой для этого использован носитель. Инвариантность информации как бы подчеркивает ее внутреннюю независимость от ее материальных оков, ее автономность и суверенность, которые сохраняются как бы наперекор судьбе, обрекающей информацию быть вечным узником мира вещей – ее физических носителей.

Инвариантность информации обусловливает возможность использовать разные способы ее фиксации на разных носителях при осуществлении разных элементарных информационных актов – создания, передачи, приема, хранения и использования информации. Для "перевода" информации с одной системы записи на другую или для перекодировки во многих информационных системах существуют специальные устройства. Перевод информации с одного языка на другой или с одной системы записи на другую возможен только благодаря свойству инвариантности. Таким образом, именно инвариантность лежит в основе возможности понимания информации – перевода ее с чуждого языка (или способа записи) на язык (или способ записи), свойственный данной информационной системе. Свойство инвариантности информации по отношению к системе записи и природе носителя также означает, что результаты ее реализации (или использования) не зависят ни от того, ни от другого, а определяются лишь ее семантикой.

Ярчайшим примером инвариантности информации может служить наше понимание генетической информации и создание искусственных генов в соответствии с заранее составленным планом.

Количество информации и емкость информационной тары

Инвариантность информации по отношению к носителям создает принципиальную возможность записи любой информации на одном и том же языке с помощью одного и того же алфавита, т. е. как бы "сведения ее к единому знаменателю". Это, хотя и не явно, было использовано К.Шенноном при решении вопроса о способе определения количества информации. Для этого можно воспользоваться формулой (12)

где М - число букв в тексте, a i - порядковый номер одной буквы в алфавите, использованном для записи информации. Здесь k - коэффициент, величина которого зависит от выбора единиц измерения количества информации и основания логарифмов. Если Н выражать в битах, то при q = 2 величина k = 2. При использовании для записи информации бинарного кода (п = 2, р1 = ро = 0,5) величина Нм = М. Другими словами, количество информации, выраженное в битах, равно числу знаков бинарного алфавита, необходимому для ее записи.

Последнее утверждение далеко не тривиально. В основе его лежит, во-первых, свойство инвариантности информации по отношению к носителям; во-вторых, представление о емкости информационной тары; в-третьих, способ количественного измерения этой емкости, которым, по существу, и является формула Шеннона. Рассмотрим эти вопросы более внимательно.

Свойство инвариантности, как мы уже видели, позволяет утверждать, что одну и ту же информацию можно фиксировать любыми носителями. Носители информации – языки, алфавиты, способы фиксации и подложки – выступают как бы в роли "информационной тары", которая может содержать информацию, причем любую. Если представление о количестве информации не лишено смысла, то отсюда следует, что для фиксации одного и того же количества информации с помощью разных носителей емкость используемой для этого информационной тары должна быть одной и той же. Полагая элементарные носители информации – отдельные буквы алфавита – дискретными, можно утверждать, что одну и ту же информацию, по меньшей мере в пределах одного и того же языка, можно записывать самыми разными алфавитами, содержащими разное число букв, в том числе и бинарным. Формула (1), показывающая, сколько битов информации содержится в некотором сообщении, по существу означает, что для записи этого сообщения бинарным кодом требуется М букв.

Формулу (1) можно записать несколько иначе, а именно (13):

Очевидно, что данная формула показывает, сколько знаков М алфавита, состоящего из п букв, требуется для записи данного количества Н информации. Очевидно, что в основе формулы (13) лежит формула (6), означающая, следовательно, сколько информации может "вместиться" в один из символов данного алфавита. Приняв в качестве единицы количества информации один бит и используя разные значения п и pi, легко убедиться, что информационная емкость отдельных символов может быть выражена любым числом, как целым, так и дробным, в том числе апериодическим. Это лучше согласуется с представлением о континуальности, нежели о дискретности самой информации, в отличие от единиц информационной тары.

Итак, мы пришли к выводу, что информационная емкость i-го символа любого алфавита, выраженная в битах, равна –log2pi, где pi есть частота встречаемости этого символа в данном языке. Это утверждение, выведенное из формулы (6) К. Шеннона, можно назвать правилом Шеннона.

Заметим, однако, что в работах самого К. Шеннона речь идет не об информационной емкости, а о количестве информации. Справедливо полагая, что количество информации, связанной с каким-либо сообщением, не должно зависеть от его семантики, К. Шеннон формулировал вопрос так: сколько информации получает адресат, воспринимая каждую из букв сообщения? Количество такой информации он и предложил выражать через величину Н и постулировал аддитивность этой величины по отношению к любому числу символов, составляющих сообщение. При этом непроизвольно произошла подмена терминов: понятие об информации, как о содержательной стороне сообщения, было подменено понятием о количестве информации, представляющем собой функцию статистических характеристик составляющих сообщение символов. Эта подмена терминов не имела никаких последствий для развития математической теории связи и даже оказалась для нее благотворной: ведь по каналам связи передают не информацию, а ее носителей, и для оптимизации работы систем связи безразлично, какую именно информацию эти носители содержат и содержат ли они ее вообще. Однако для теории информации эти различия весьма существенны, и вот почему.